集成算法区别 集成算法优缺点

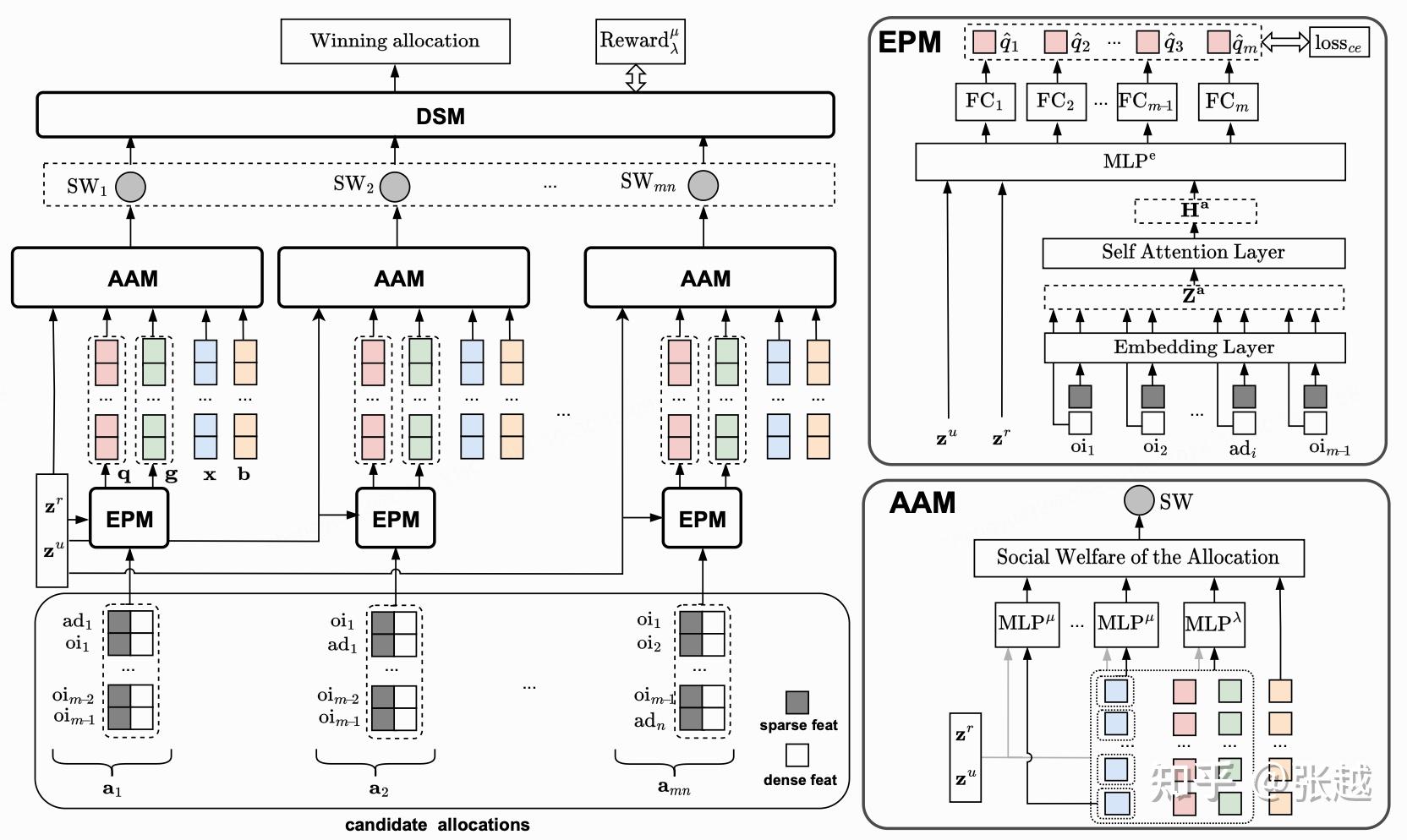

集成算法类似于将多个专家集成算法区别的意见结合起来集成算法区别,每个专家提供简单的算法模型,共同决策以得出结果集成算法比单个模型的预测结果更精确,但需要更多的维护工作2 回归算法 回归分析基于已知自变量和因变量之间的相关关系,建立它们之间的回归方程,将回归方程作为算法模型,用于预测新自变量与因变量之间的关集成算法区别;集成算法,即Bagging算法,是一种在机器学习领域用于提升模型准确率与稳定性,同时降低过拟合风险的团体学习策略Bagging的核心思想在于构建多个弱学习器,这些学习器之间是并行关系,可同时训练,最终通过组合它们的预测结果来提高整体性能Bagging算法原理图展示了其工作流程首先,通过有放回地随机抽取原始;基础算法简单实用,包括简单线性回归多元线性回归决策树和逻辑回归其中,简单线性回归和多元线性回归主要用于预测,如预测客户收入或项目收益决策树则是基于树状图的分类和预测方法,拥有解释性强易于理解等优点,是集成算法的基础逻辑回归则常用于解决二分类和多分类问题,特别是在风控建模中集成;2集成算法类似于将多个专家的意见结合起来做出决策与单个模型相比,集成算法能提供更精确的预测结果,但同时也需要更多的维护工作二回归算法 回归算法主要用于分析自变量与因变量之间的相关关系1通过建立变量之间的回归方程,回归算法可以对新的自变量进行预测,得出相应的因变量值2回归算法不仅;集成学习是一种将多个分类器组合,形成预测效果更优的集成分类器的策略Thomas G Dietterich指出,集成算法在统计计算和表示上皆有显著优势集成算法主要分为BaggingBoosting和Stacking,其中Bagging与Boosting最为人所熟知Bagging通过有放回抽样可能抽取重复样本,实现对输入数据的多样性和多样性;集成算法,是一种提高弱分类算法准确度的方法,将多个弱分类算法也称为基学习器以一定的集成方式集合在一起,然后再将弱分类器的结果以一定的融合策略融合成一个结果,作为最终的结果输出集成算法通过将多个学习器进行结合,常可获得比单一学习器显著优越的泛化性能基学习器的集成方式大致分为以下;bagging与boosting是两种不同的集成算法,Bagging采用重复取样boostrap每个个体分类器所采用的训练样本都是从训练集中按等概率抽取的,因此Bagging的各子网能够很好的覆盖训练样本空间,从而有着良好的稳定性而Boosting注重分类错误的样本,将个体子网分类错误的训练样本的权重提高,降低分类错误的样本权重,并。

集成算法好于单独算法是因为集成算法好处就是团结力量大,各方面的计算数据更加全面单个算法如果有短板,也会影响整个输出从集成学习的思想来看,其实不单单只是集成百家之长去得到一个最准确的最终分类器这么简单,这样看来会造成过拟合问题,然而,集成算法的优势就是在于比其集成算法区别他类型的分类器更容易避免;集成AI引擎AIE和八核是两种不同的概念,它们在技术和用途上存在一些区别集成AI引擎AIE集成AI引擎是一种专门为移动设备和嵌入式系统设计的人工智能处理器它通常由多个核心单元Core组成,内置了专门的硬件加速器以执行AI相关的计算任务,如图像处理语音识别和自然语言处理等AIE通常具有;集成分类算法随机森林通过组合多个决策树提高性能,但可能过拟合AdaBoost通过调整样本权重,组合多个弱分类器GBDTXGBoost梯度提升决策树,通过迭代优化提高性能简化或效率提升的算法决策树桩简化版的决策树,通常作为集成算法的一部分K最近邻朴素贝叶斯结合KNN和朴素贝叶斯的特点,以提高。

神经网络深度学习的基石,强大但训练过程复杂,需要大量计算资源贝叶斯网络利用概率链规则,适用于处理因果关系,但模型构建需要专业知识LDA主题模型,用于文本分类,有助于揭示数据的潜在主题最大熵模型追求最大不确定性下的最优预测,适用于信息检索等领域集成算法篇随机森林通过集成多个;集成学习通过组合多个学习器,提升整体性能,即使单个分类器表现不佳可分为同质基于相同算法的基学习和异质系统目标是通过弱学习器形成强学习器,同时兼顾效率和多样性集成学习方法分为两类Boosting如AdaBoost, GBDT, XGBoost和Bagging如随机森林Boosting如AdaBoost,强调通过关注分类;集成学习是一种通过训练多个弱学习器,形成一个强学习器的方法,适用于监督学习分类和回归是根据输出变量的类型区分的两类问题集成学习中,个体学习器“好而不同”至关重要,即每个学习器都应有较高的准确性和一定的多样性,避免学习器之间存在高度相关性随着个体学习器数量的增加,集成的错误率将。

一集成算法1简单算法一般复杂度低速度快易展示结果,其中的模型可以单独进行训练,并且它们的预测能以某种方式结合起来去做出一个总体预测2每种算法好像一种专家,集成就是把简单的算法组织起来,即多个专家共同决定结果集成算法比使用单个模型预测出来的结果要精确的多,但需要进行大量的维;1 Boosting 概述Boosting是一种集成学习方法,它通过组合多个弱学习器来形成一个强学习器 工作原理Boosting算法强调通过关注分类错误的样本,在逐次迭代中不断提高性能常见的Boosting算法有AdaBoostGBDT和XGBoost等 特点AdaBoost通过调整样本权重,使分类错误的样本在后续迭代中获得更多关注GBDT。

GBDT中的决策树是回归树而非分类树每棵树的结论并不是样本目标值本身,而是目标值的一个累加量核心思想每一棵树拟合的是之前所有树结论和的累加值的残差具体实现方式是每一棵树拟合的是损失函数在前一棵树上的负梯度集成算法与BoostingGBDT是boosting算法的一种,而boosting又是集成算法。

0 Comments

给我留言